今回の記事ではLM StudioでLLM Serverを立ち上げ、VS CodeとContinueのPlugins連携でAIコーディングを体験してみます。

さ、FAを楽しもう!

前書き

いつも私の技術ブログとYouTubeチャンネルをご覧いただき、心より感謝申し上げます。また、いまFullさん(full@桜 八重 (@fulhause) / X)と共に毎週水曜日の夜にお届けしている「高橋クリス」ラジオ番組を運営しています。

技術は独り占めせず、届けるもの

私たちは工場の生産技術や制御に関する技術情報を、ブログや動画などで無料公開しています。「知識は誰でもアクセスできるべき」という信念のもと、現場で役立つ具体的なノウハウやトラブル事例などを発信してきました。すべて無料で続けているのは、「知らなかったせいで困る人」を少しでも減らしたいからです。

また、もしあなたの現場で…

- 「このPLCとデバイスの組み合わせ、ちゃんと動くのかな?」

- 「EtherCAT通信でうまくいかない部分を検証してほしい」

- 「新しいリモートI/Oを試したいけど社内に検証環境がない」

など、困っている構成や試してみたいアイデアがあれば、ぜひお知らせください。機器の貸出や構成の共有が可能であれば、検証し、記事や動画で発信します(ご希望に応じて匿名対応も可能です)。

支援のかたち

現在、私達の活動はほぼ無償で続けており、記事や動画の制作には、時間と検証環境の整備が必要です。この活動を継続的にコンテンツを提供するためには、皆様の温かいご支援が大変重要です。

メンバーシップ(ラジオの応援)

Fullさんとのラジオをより充実させるための支援プランです。

https://note.com/fulhause/membership/join

Amazonギフトリスト

コンテンツ制作に必要な機材・書籍をリストにしています。

https://www.amazon.co.jp/hz/wishlist/ls/H7W3RRD7C5QG?ref_=wl_share

Patreon(ブログ・動画活動への応援)

月額での小さなご支援が、記事の執筆・検証環境の充実につながります。

https://www.patreon.com/user?u=84249391

Paypal

小さな支援が大きな力になります。

https://paypal.me/soup01threes?country.x=JP&locale.x=ja_JP

知ってたら助かること、届けたいだけです

あなたの応援が、知識の共有をもっと自由で持続可能なものにしてくれます。これからもどうぞよろしくお願いします。

soup01threes*gmail.com

技術はひとりじゃもったいない。

Reference Link

http://soup01.com/ja/category/ai/lm-studio/

VS Continue Plugin?

VS Continue Pluginは、ひと言で言うと,、「エディタの中に“会話できる頭脳”を住まわせるためのVS Code拡張」です。Continueは VS Code内で動くAIコーディングアシスタントで、ChatGPT系やローカルLLMとつながり、次のことができます。

- 選択中のコードを その場で説明

- 「ここ直して」「この処理を速く」など 自然文でリファクタ

- ファイル全体やプロジェクト文脈を読んだ上での回答

- コメント生成、テスト生成、仕様理解の補助

また、ローカルLLMともつながることは、Continueのよいところです。つまり…社内コードを外に出さずにAI支援ができ、製造業・制御系エンジニアには特に相性がいいかもしれません。

構築

LM Studio

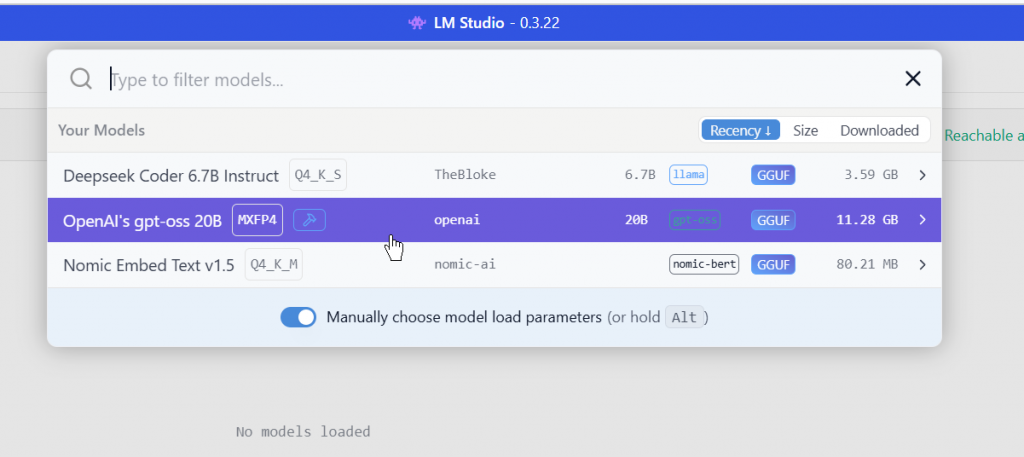

最初にLM Studio側を設定します。

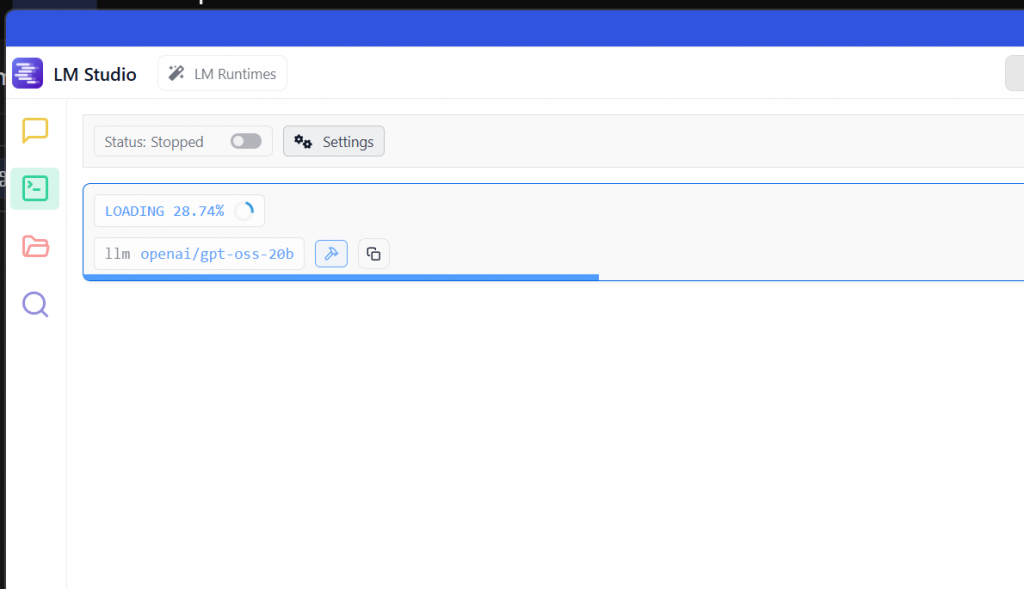

Start Server

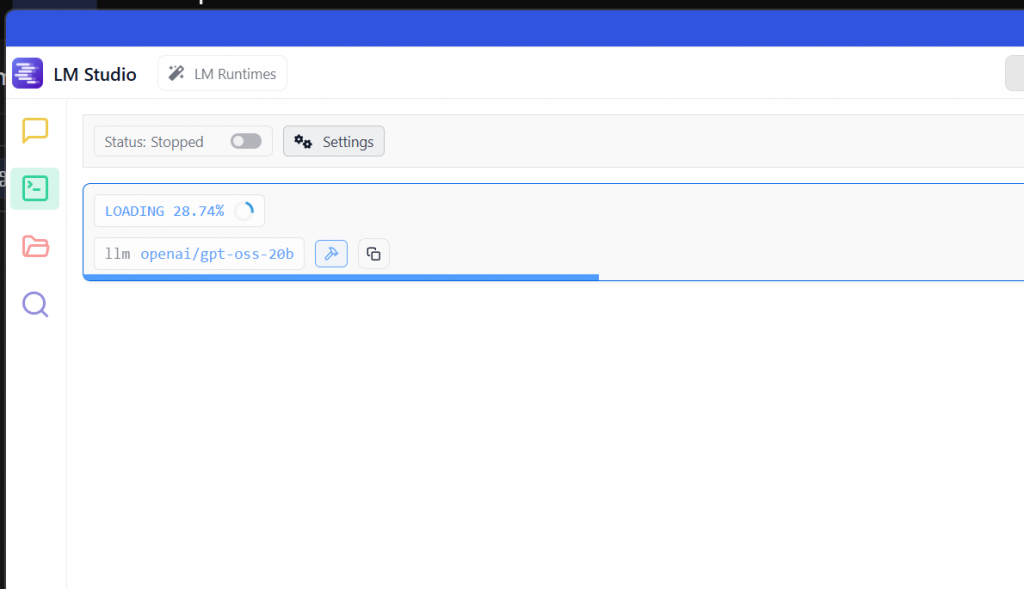

LM Studioを起動し、Developer Tabを開きます。

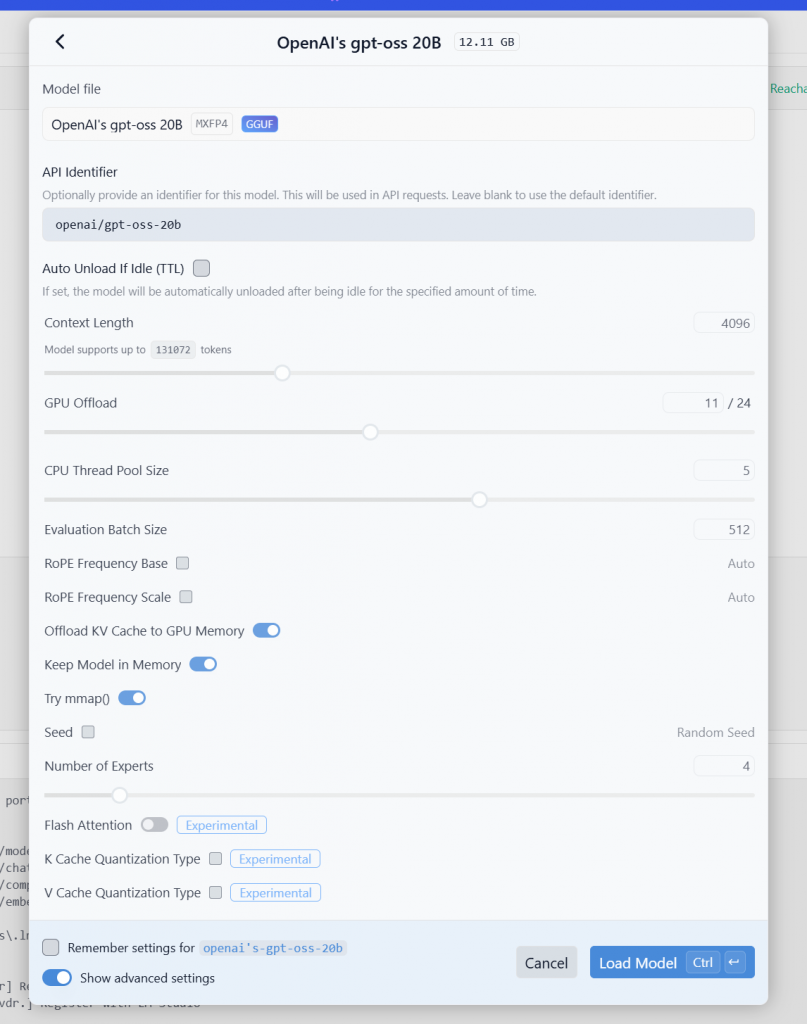

LM studioから起動するモデルを選択します。今回の記事では12GBくらいあるのgpt-oss 20Bに使用します。

Load Modelで進みます。

少々お待ち下さい…

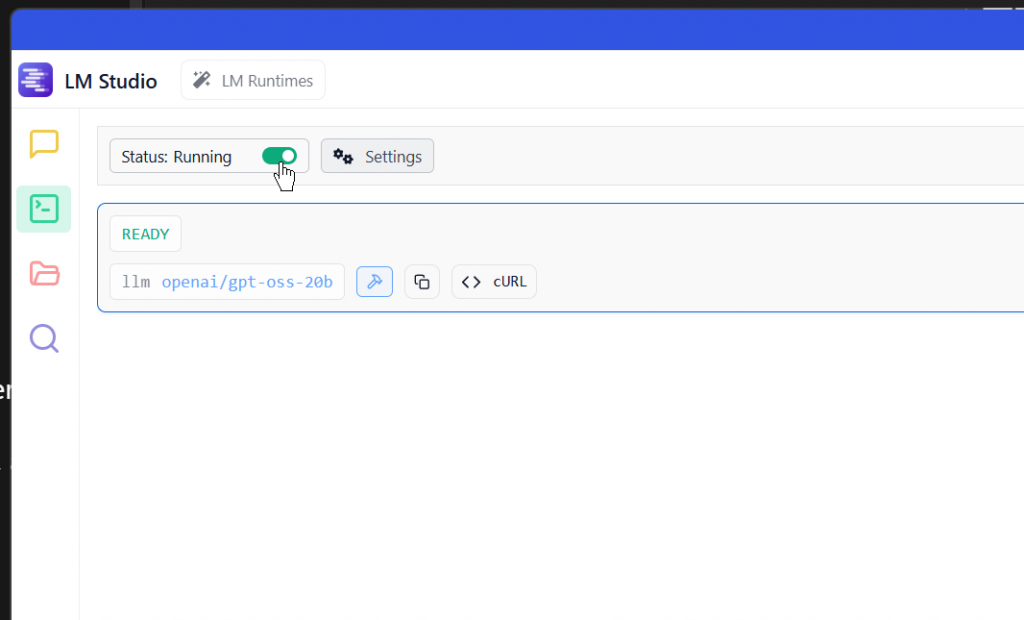

LM Studioにモデルをロード完了したらStatus RunningのRadioボタンをONします。

API Usge

次はLM Studioの側にあるAPI Usageに現在使用してるモデルとServerのIPアドレスが表示されます。その設定は後ほどVS Codeに使われます。

VS Code

次はVS Code側を設定します。

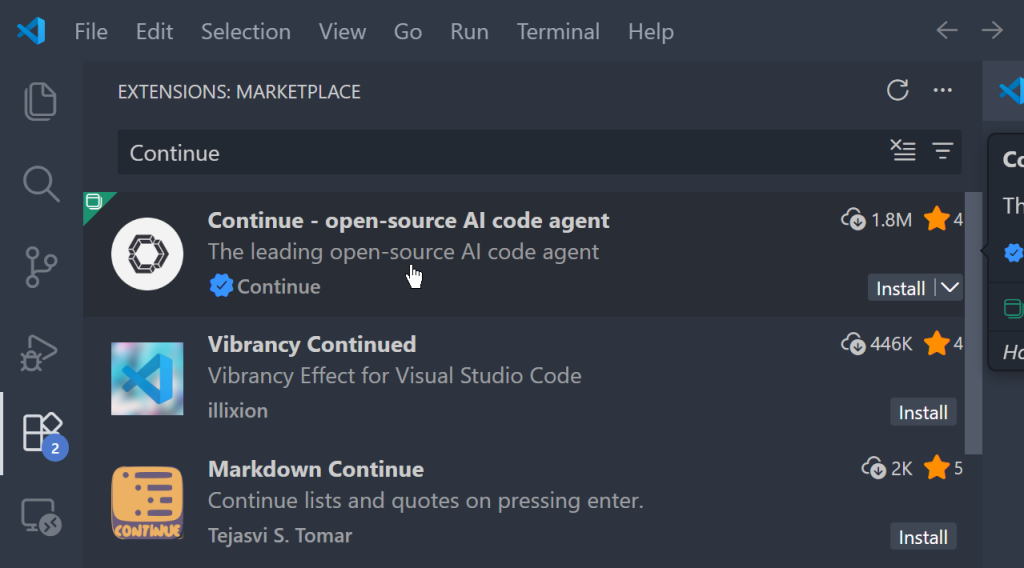

Install Continue

最初にVS Code側にContinue のPlug-insをインストールします。

Configure Local

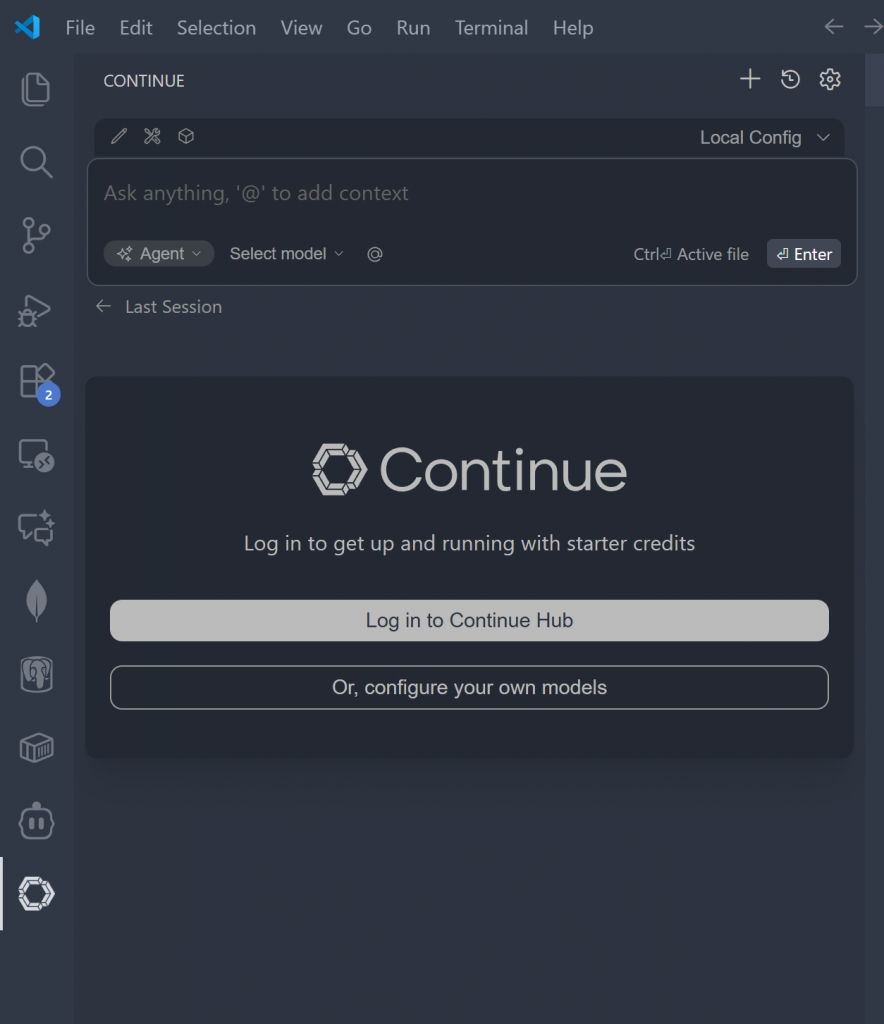

Continue Pluginの設定画面を開き、今回記事で使用するLM StudioのLocal サーバと接続する設定を行います。

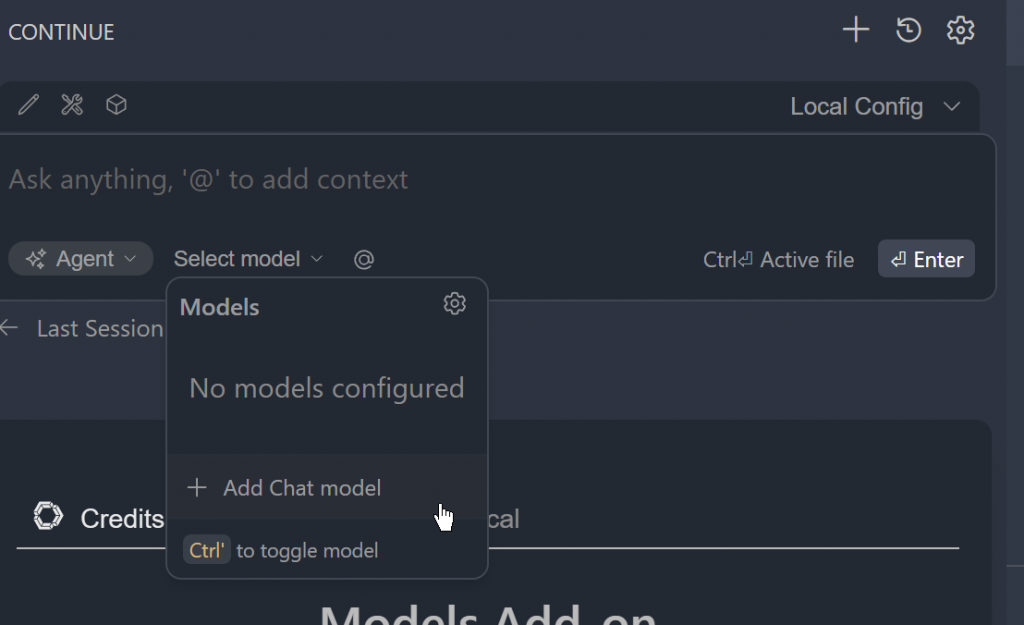

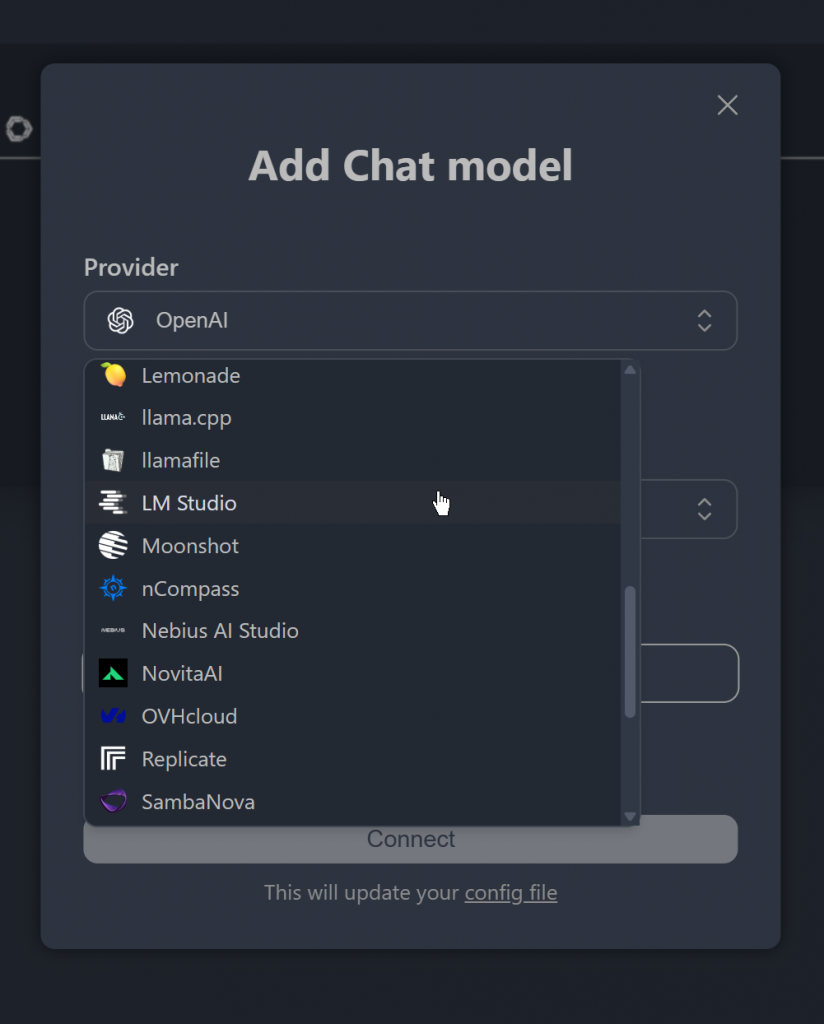

Add Chat model

Select Model→Add Chat Modelをクリックします。

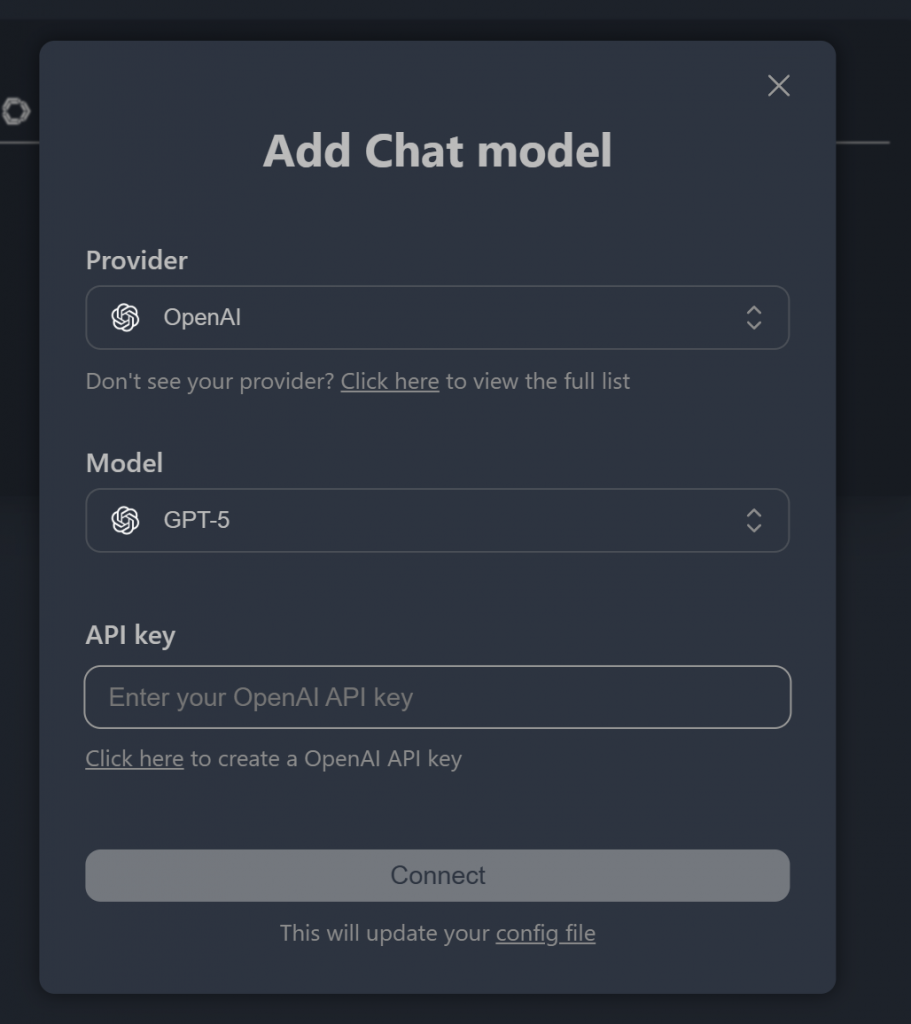

こちらはChat Modelの設定画面になります。

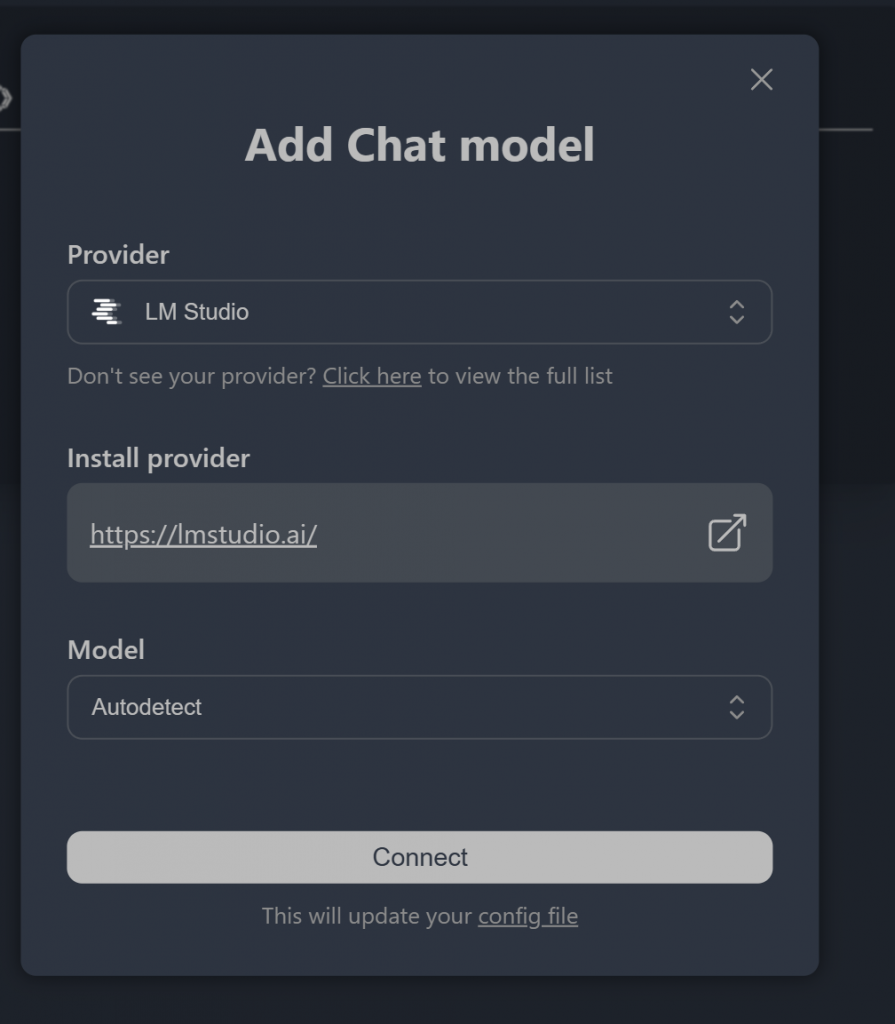

Provider のDrop-listからLM Studioを設定します。

ModelをAutodetectに設定し、Connectをクリックしましょう。

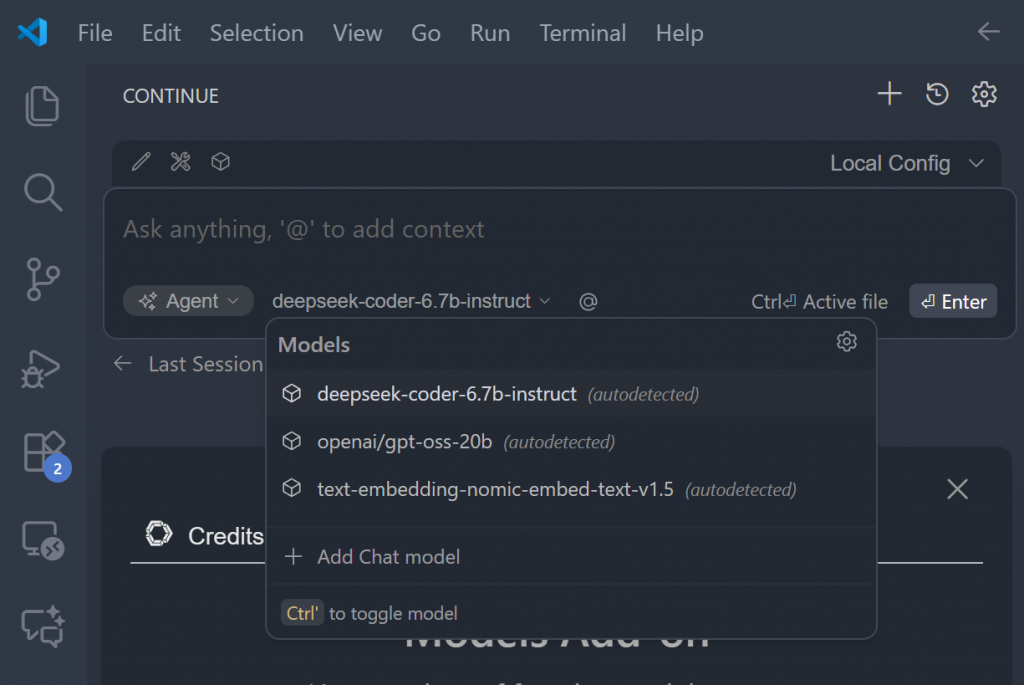

Choose Models

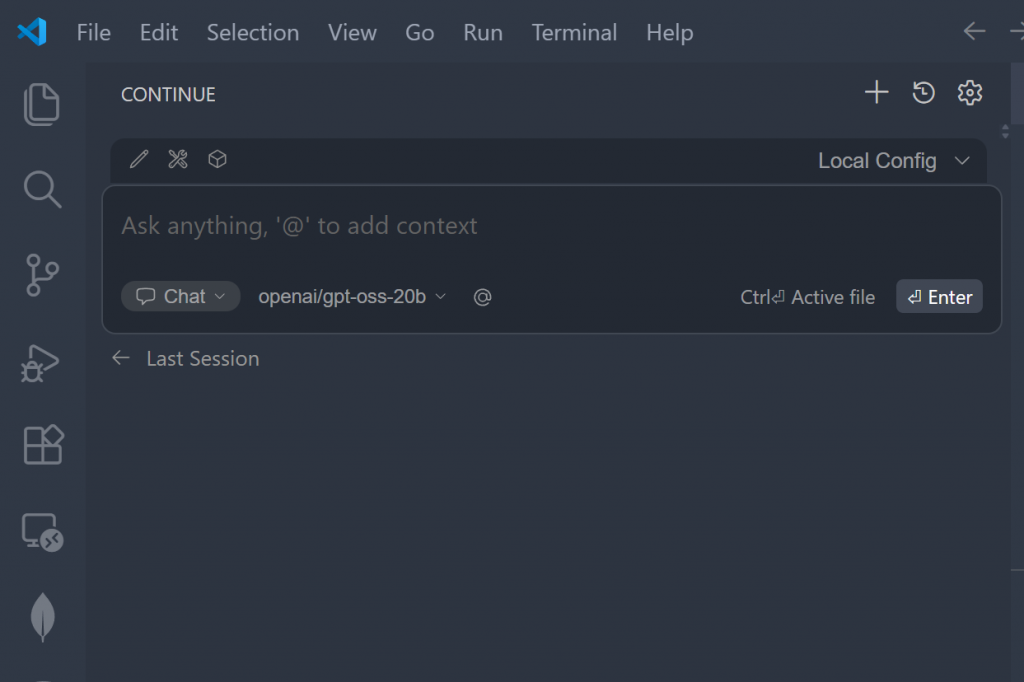

次はモデルの設定Drop-listからLM Studioで使用してるモデルを設定します。

Test it!

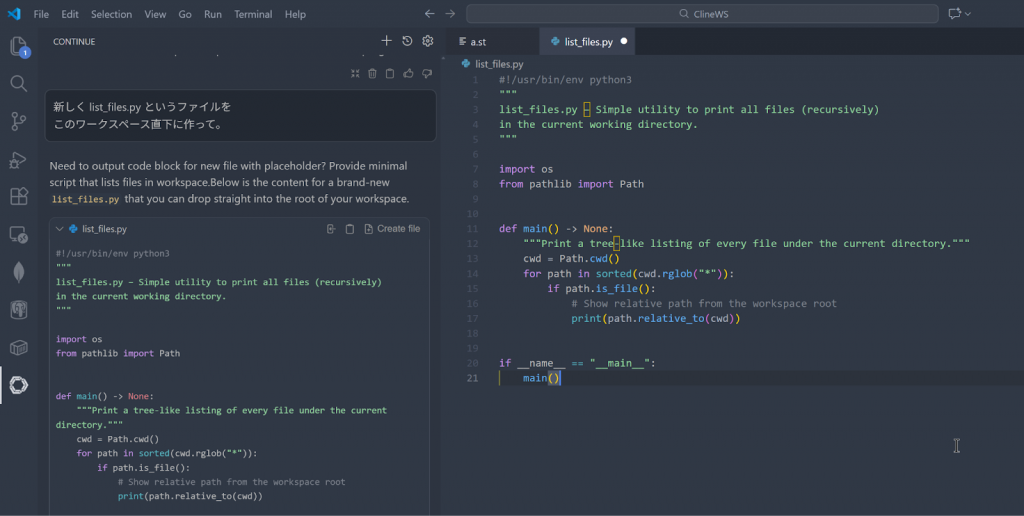

Done!最後はプログラムを作ってみましょう!

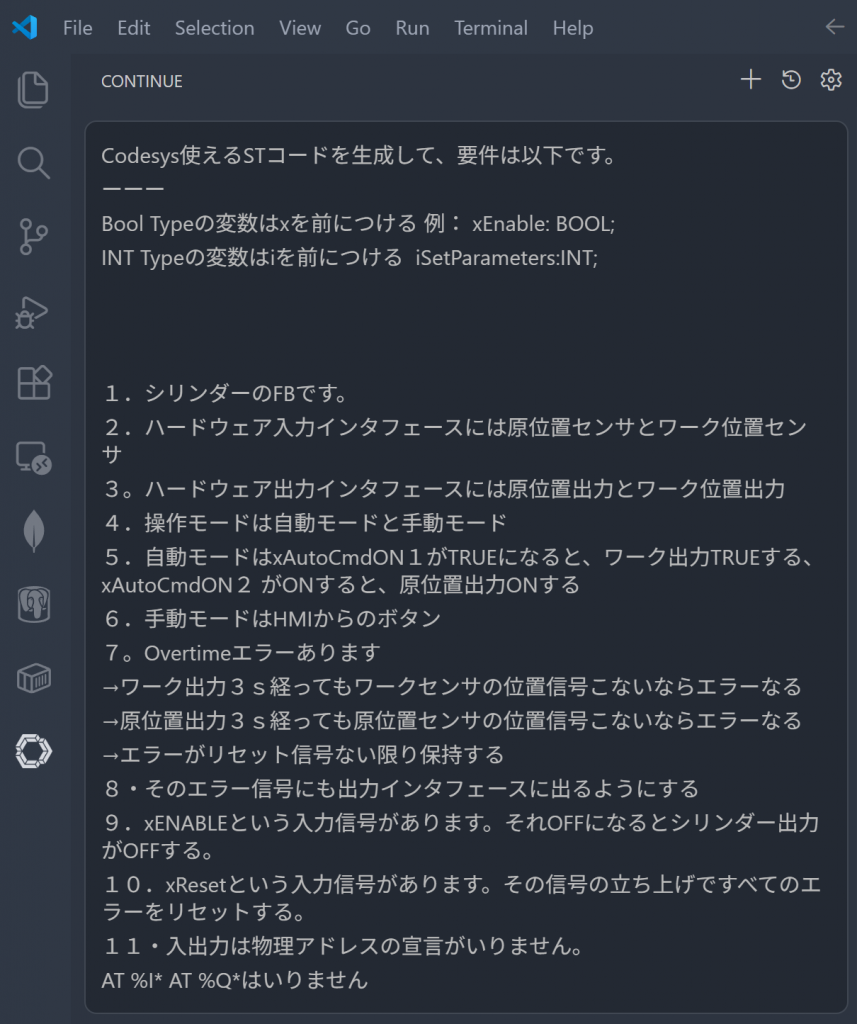

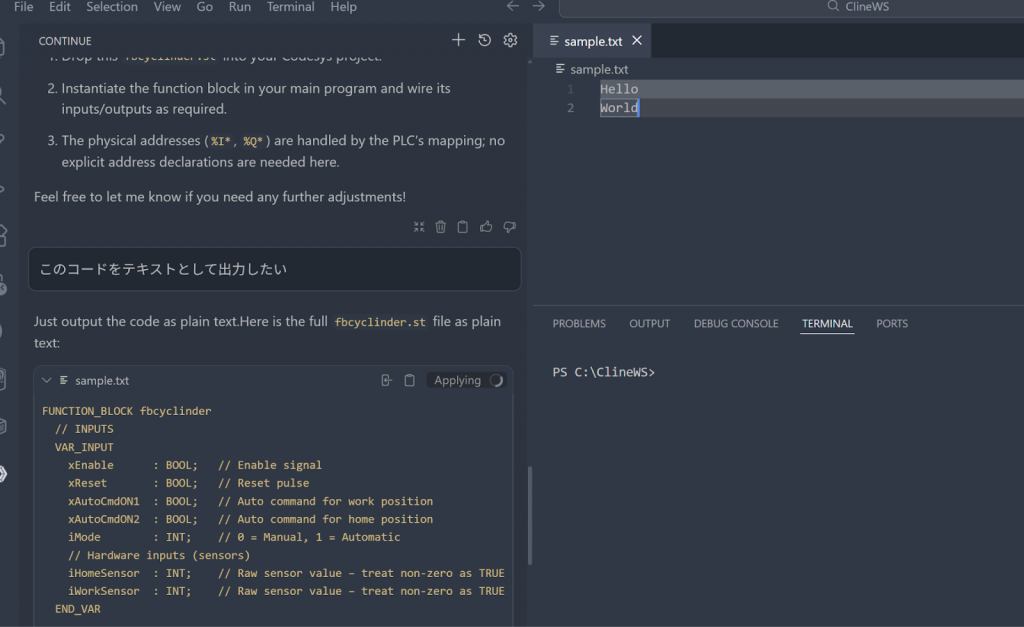

CONTINUEのPlug-inにCodesysブログラムの仕様を提出します!

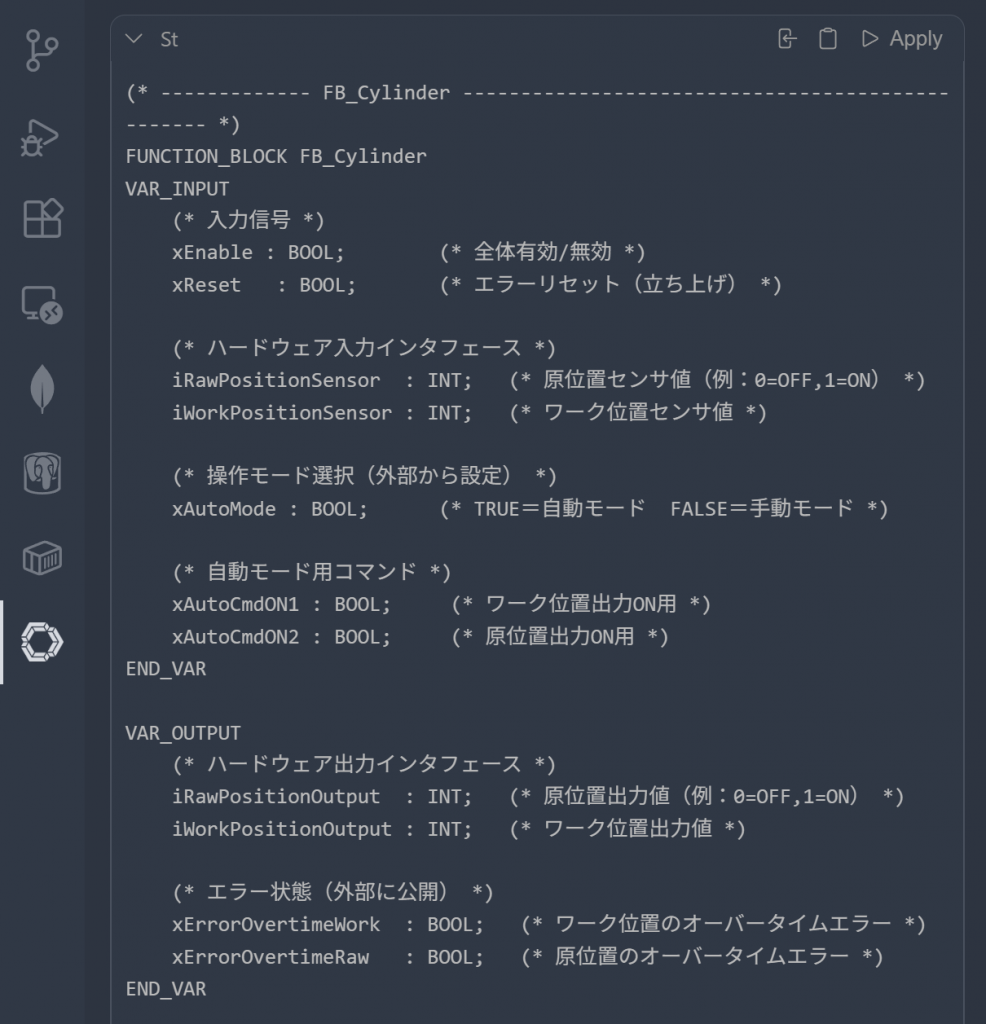

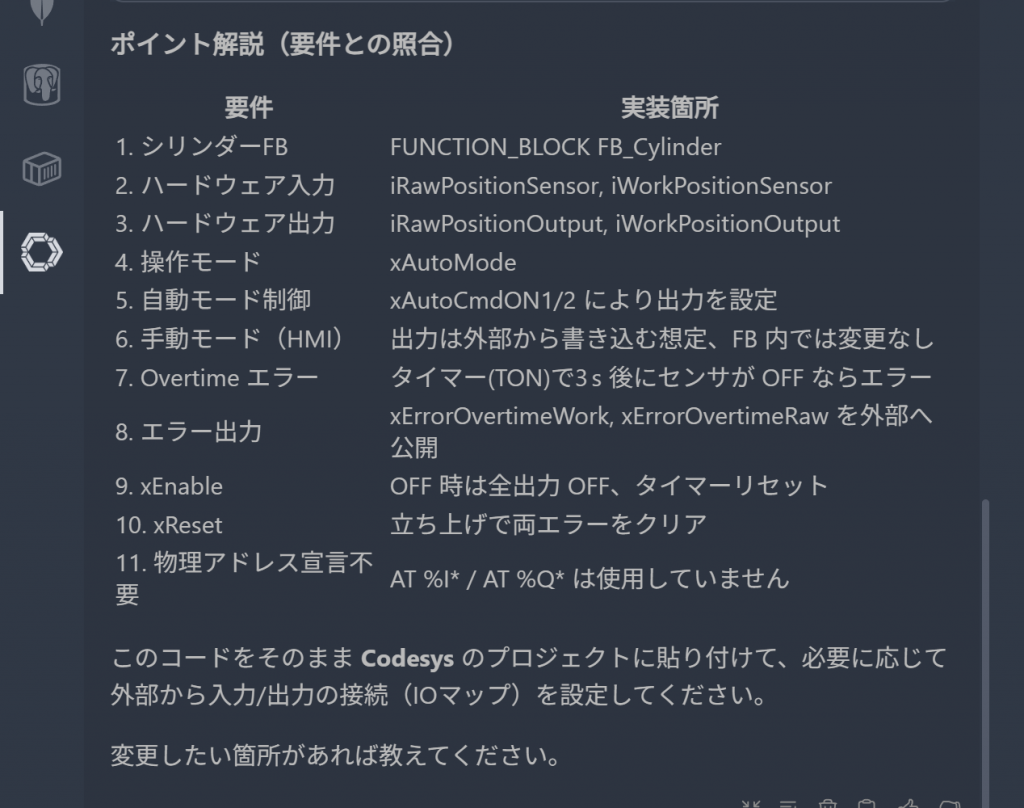

Done!CONTINUEがLM StudioのServerからCodesysのST コード生成ができました。

コメントやコードの簡単説明にもついています。

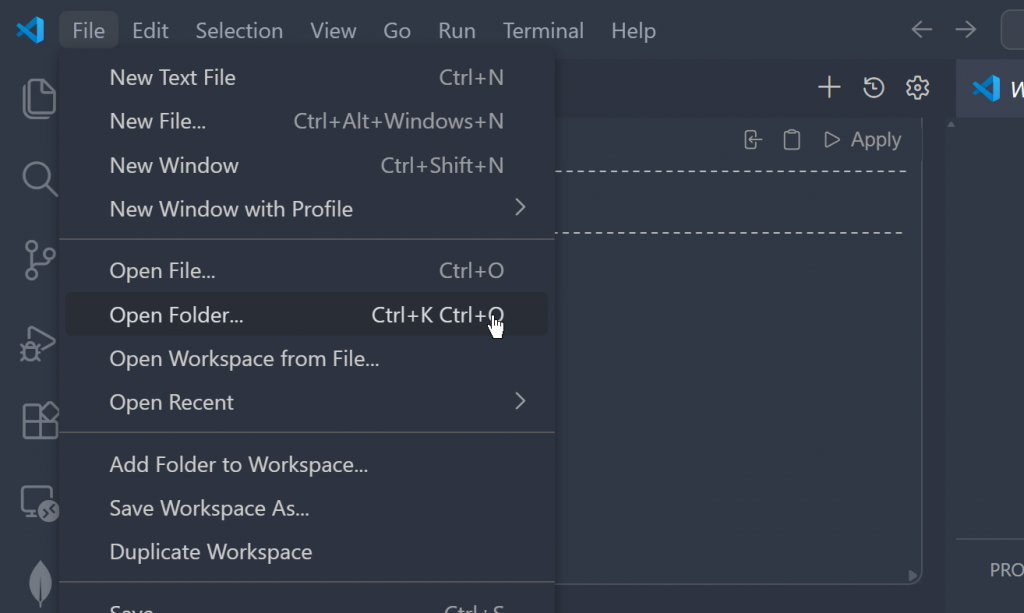

最後はそのコードをテキストとして出力したいので、File→Open Folderで作業するFolderを開きます。

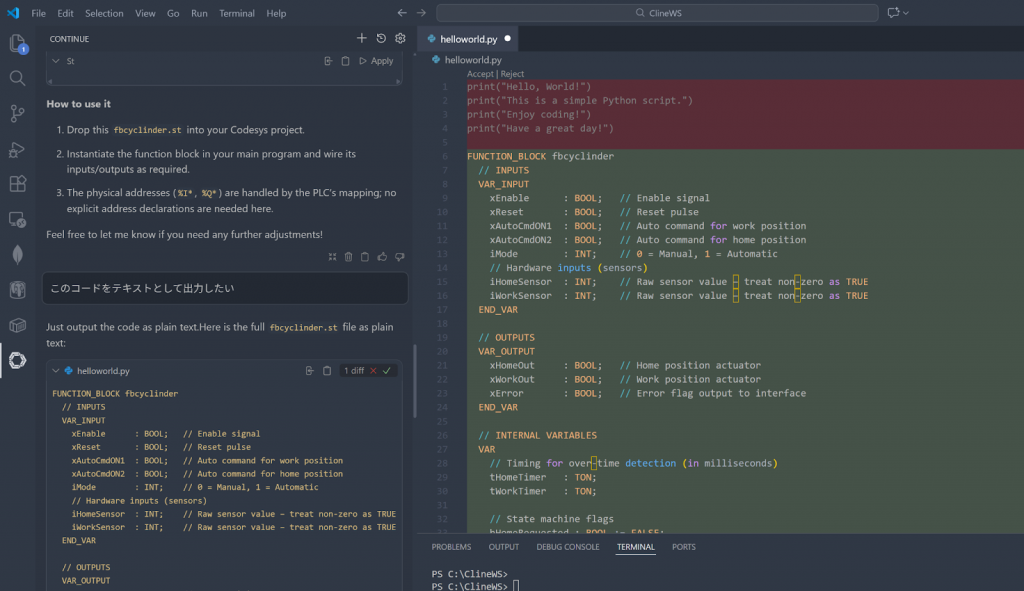

Fileを開き、右側にあるApplyボタンをクリックします。

Done!プログラムが貼り付けられただけではなく、差分にも表示されます。

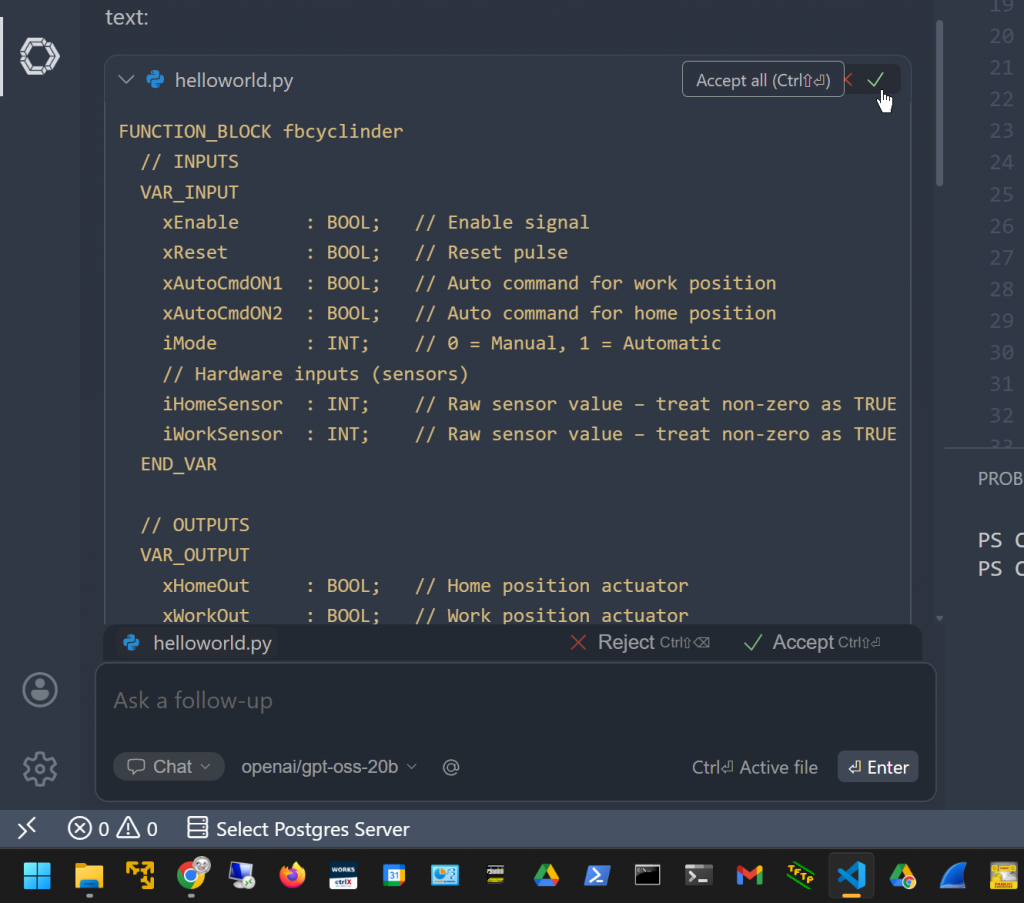

Accept Allをクリックします。

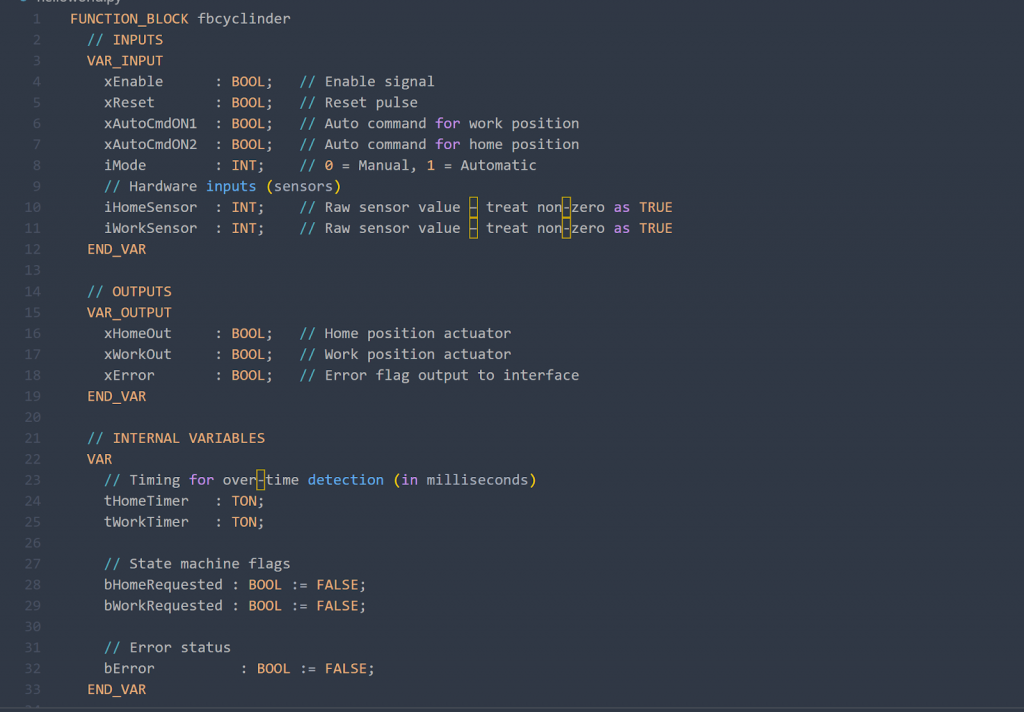

Done!

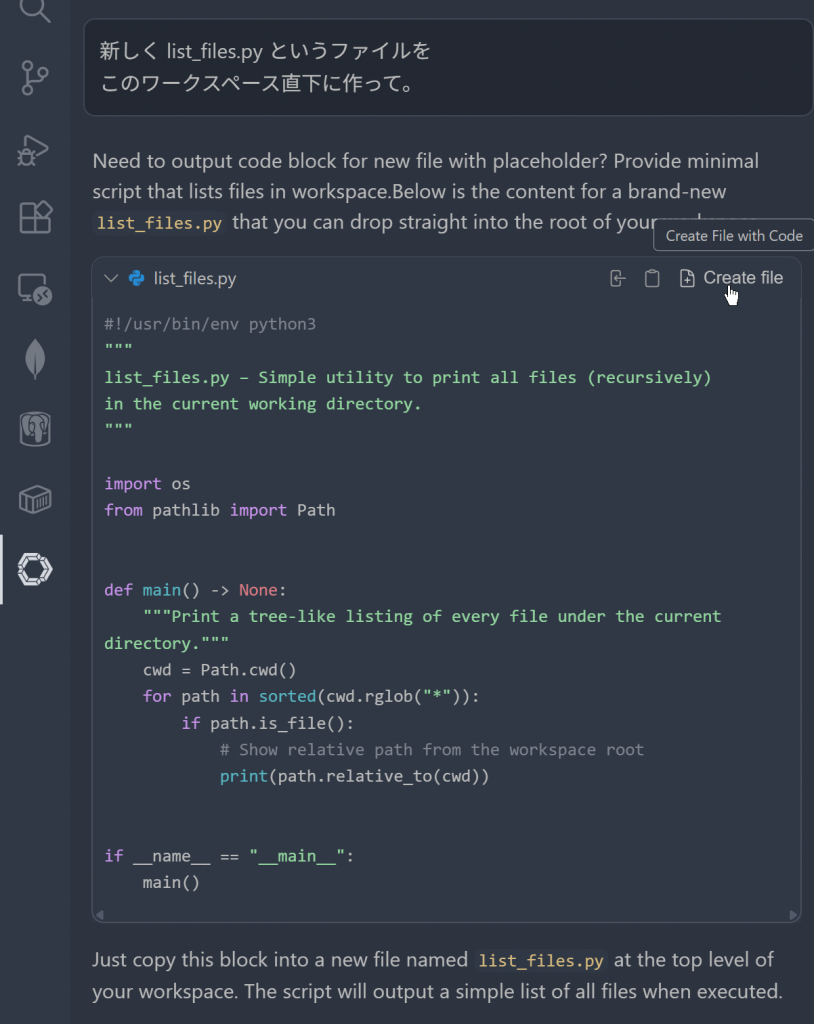

また、Create Fileというボタンをクリックし、生成したコードをそのままテキストFILEとして作成できます。

Done!